Die KI-Illusion: Technische Realität hinter dem Hype

Table of Contents

Ich möchte niemanden von etwas überzeugen, was er nicht selbst sieht – das ist sinnlos.

Aber ich glaube, es ist wertvoll, eine fundierte Meinung zu haben. Und dafür brauchen wir Zugang zu alternativen Perspektiven, besonders wenn der Marketing-Hype die Erzählung dominiert.

Dieser Artikel kombiniert technische Analyse mit kritischen Perspektiven führender KI-Forscher.

Teil 1: Was LLMs wirklich sind#

Was ist ein LLM?#

Ein Large Language Model (LLM) wie GPT-4 ist eine riesige statistische Maschine, die das wahrscheinlich nächste Wort in einem Satz auf Basis von Trainingsdaten vorhersagt.

Es denkt nicht. Es versteht nichts. Es vervollständigt lediglich Muster.

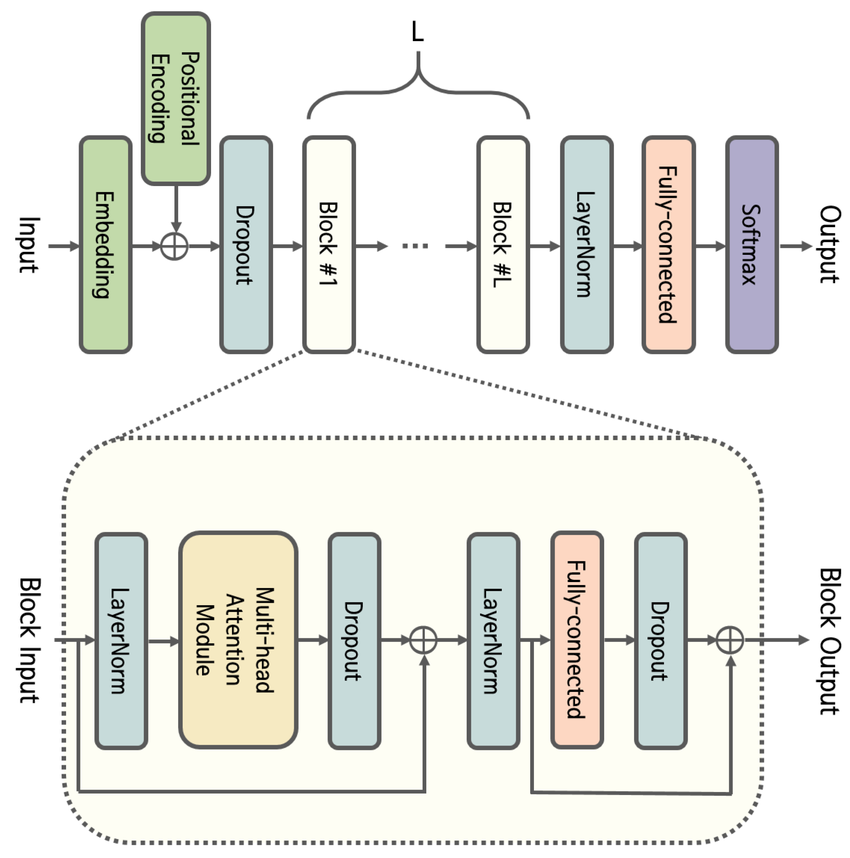

Wie funktionieren Transformer?#

- Eingaben (Tokens) werden in Vektoren umgewandelt.

- Selbst-Attention-Schichten berechnen die Beziehungen zwischen Tokens.

- Das Modell sagt das nächste Token mit statistischer Gewichtung voraus.

Es existiert kein Weltmodell, kein Bewusstsein, keine Logik-Instanz.

Beispiel:

Eingabe: „Die Katze saß auf der…"

Ausgabe: „…Matte" (höchste statistische Wahrscheinlichkeit im Trainingskorpus)

Warum das keine Intelligenz ist#

- Kein Verständnis von Bedeutung.

- Kein Gedächtnis zwischen Sitzungen (außer extern implementiert).

- Keine Intention oder Ziel – nur Mustervervollständigung.

LLMs sind ELIZA auf Steroiden: sprachlich beeindruckend, skaliert – aber inhaltlich leer.

LLMs sind wie extrem schnelle Autovervollständiger mit riesigem Speicher – aber keine Denkmaschinen.

Quelle: ResearchGate, CC BY-NC-ND 4.0

Teil 2: Warum Statistik ≠ Denken#

Transformermodelle „denken" nicht – sie optimieren Wahrscheinlichkeiten.

Ihr Output ist beeindruckend, aber völlig nicht-konzeptuell.

Warum Transformer nicht denken#

Trotz aller Begeisterung fehlt Transformer-basierten Modellen (wie GPT) das, was echte Denkprozesse ausmacht:

- Kein echtes Weltwissen

- Kein Verständnis von Ursache und Wirkung

- Keine Intentionen oder Ziele

- Kein Selbstmodell oder Modell anderer

- Keine echte Abstraktion oder symbolische Verankerung

- Kein mentales Zeiterleben (Gedächtnis/Planung)

Sie sind statistische Spiegel, keine kognitiven Agenten.

Ein Transformer ist kein Geist – nur ein ausgeklügelter Papagei mit riesigem Echo.

Neural ≠ Human#

Transformer sind nicht gehirnähnlich.

Sie imitieren keine kortikalen Prozesse, kein dynamisches Lernen, keine biologischen Rückkopplungsschleifen.

Sie erkennen Muster – aber verstehen sie nicht.

In der Neurowissenschaft ist Intelligenz mehr als Vorhersage:

Es geht um die Integration von Wahrnehmung, Gedächtnis, Kontext und Motivation in sinnvolles Verhalten.

Transformer leisten das nicht.

Siehe:

- Rodney Brooks – Intelligence without representation

- Yoshua Bengio – System 2 Deep Learning and Consciousness

- Karl Friston – Active Inference Framework

Täuschende Oberfläche, fehlende Tiefe#

Transformer simulieren Sprachflüssigkeit, aber kein Verstehen.

Sie können:

- Ein juristisches Argument nachahmen

- Eine poetische Antwort schreiben

- Einen philosophischen Dialog fortsetzen

Aber sie können nicht:

- Verstehen, was ein Vertrag ist

- Die emotionale Tiefe einer Metapher erfassen

- Über die Bedeutung einer Frage reflektieren

Das ist der ELIZA-Effekt in großem Maßstab:

Wir projizieren Denken in statistischen Output.

Transformer als Sackgasse?#

Der aktuelle KI-Kurs steckt in einem lokalen Maximum:

Mehr Daten – größere Modelle – besser klingende Texte… aber kein Schritt Richtung echtes Verstehen.

Skalierung ist kein Ersatz für Erkenntnis.

Echte KI könnte erfordern:

- Symbolverankerung

- Verkörperung

- Kontinuierliches Lernen

- Kausales Denken

- Kognitive Architekturen jenseits von Transformern

Siehe:

- Gary Marcus – Deep Learning Is Hitting a Wall

- Timothy Shanahan – Transformers lack abstraction

- Neurosymbolische Ansätze – MIT-IBM Watson AI Lab

Teil 3: Stimmen kritischer KI-Forschung#

Hier sind einige führende Stimmen von KI-Forschern, die die Bezeichnung „Künstliche Intelligenz" und die damit verbundenen Risiken kritisch hinterfragen:

Emily M. Bender: „Stochastische Papageien"#

Emily Bender hat den Begriff „Stochastische Papageien" geprägt, um zu beschreiben, wie Modelle wie ChatGPT statistisch plausible Texte erzeugen, ohne echtes Verständnis zu haben.

👉 ai.northeastern.edu

👉 The Student Life

Timnit Gebru: Strukturwandel für ethische KI#

Timnit Gebru betont die Notwendigkeit systematischer Reformen, um eine ethische KI-Entwicklung zu ermöglichen.

👉 WIRED

Gary Marcus: Regulierung gegen KI-Hype#

Gary Marcus fordert eine starke staatliche Aufsicht, um Schaden durch unregulierte KI-Systeme zu verhindern.

👉 Time

Meredith Whittaker: KI als Überwachungskapitalismus#

Meredith Whittaker sieht KI als in systematischer Datenausbeutung und Machtkonzentration verwurzelt. Sie warnt, dass agentische KI die Sicherheit auf Anwendungsebene gefährden und die Privatsphäre von Millionen von Nutzern bedrohen könnte.

Whittaker betont, dass die großen KI-Spieler Technologien mit Überwachung als Geschäftsmodell entwickeln. Diese Dienste sind zwar zunächst kostenlos, aber im Hintergrund werden riesige Datenmengen erzeugt, gespeichert und der Werbeindustrie zugänglich gemacht.

👉 Observer – Signal’s Whittaker on AI Privacy Risks

👉 The Economist – AI agents are coming for your privacy

👉 NZZ – Signal-Chefin warnt vor KI-Agenten

Sandra Wachter: Recht auf Erklärbarkeit#

Sandra Wachter fordert rechtliche Rahmenwerke, um algorithmische Verantwortlichkeit und Fairness zu gewährleisten. Ihre Arbeit konzentriert sich auf die rechtlichen und ethischen Implikationen von Big Data, Künstlicher Intelligenz und Algorithmen.

Wachter hat zahlreiche Fälle hervorgehoben, in denen undurchsichtige Algorithmen zu diskriminierenden Ergebnissen geführt haben, wie z.B. die Diskriminierung bei Bewerbungen am St. George’s Hospital in den 1970er Jahren und die Überbewertung von schwarzen Strafgefangenen bei COMPAS.

Sie hat Werkzeuge entwickelt wie kontrafaktische Erklärungen, die es ermöglichen, Algorithmen zu hinterfragen, ohne Geschäftsgeheimnisse preiszugeben. Dieser Ansatz wurde von Google auf TensorBoard und von Amazon in ihren Cloud-Diensten übernommen.

Fazit#

Transformer sind sprachliche Illusionen.

Sie simulieren Kompetenz – besitzen aber keine.

Der Weg zu echter KI führt nicht über immer größere Sprachmodelle.

Er führt über ein neues Verständnis davon, was Intelligenz wirklich ist –

nicht nur, wie sie klingt.

LLMs sind mächtige Werkzeuge – aber sie als „intelligent" zu bezeichnen, ist irreführend.

Diese Seite zeigt auf, wie dieses Etikett genutzt wird, um die öffentliche Wahrnehmung zu manipulieren.

Wir sollten nicht länger fragen: „Wie gut klingt der Output?"

Sondern: „Was für ein System erzeugt ihn?"

Related Posts

- Grok ist im Arsch - Eine tiefgreifende Analyse seiner Grenzen und Fehler

- 'ELIZAs Regeln vs. GPTs Gewichte: Gleiche Symbolmanipulation, nur größer'

- AI mal nüchtern betrachtet: Warum Large Language Models brillante Tools sind – aber keine Magie

- ChatGPT Search: Google-Killer oder Zensur-Upgrade? Ein kritischer Blick hinter die KI-Suchmaschine

- Digitale Verblödung? – Wie Technik uns das Denken abnahm | 7 Phasen erklärt