KI-Modelle schreiben wie Vierer-Schüler: Was 66% Benchmark-Scores wirklich bedeuten

Die “besten” KI-Modelle der Welt: Eine Realitätsprüfung#

Alle reden von der KI-Revolution. Superintelligenz steht vor der Tür. AGI kommt jeden Tag. Aber was sagen die echten Benchmarks, wenn wir standardisierte Tests über 171+ verschiedene Aufgaben hinweg betrachten?

Die Zahlen sind ernüchternd:

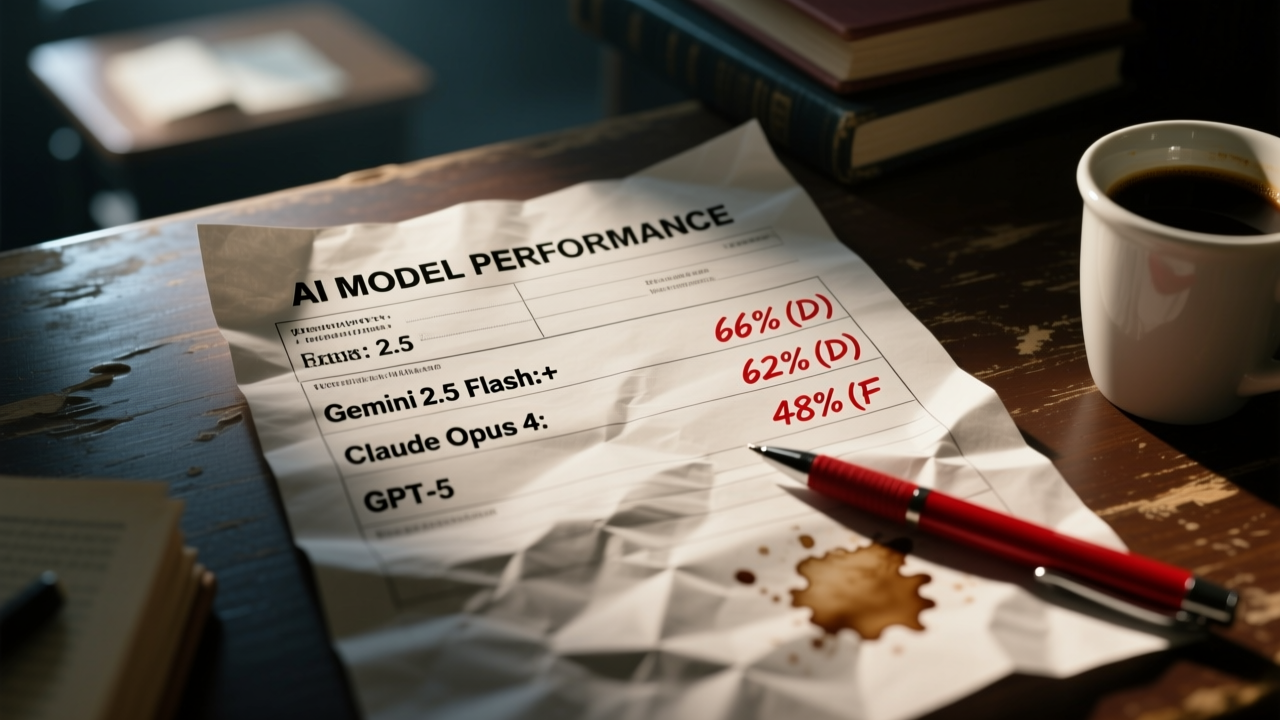

| Modell | Gesamt-Score | Fehlgeschlagene Aufgaben | Schulnote |

|---|---|---|---|

| Gemini 2.5 Flash | 66% | 1 von 3 | 4+ |

| Claude Opus 4 | 62% | ~2 von 5 | 4 |

| GPT-5 | 48% | 1 von 2 | 5 (nicht bestanden) |

Lass das mal sacken. Das sind keine gezielt ausgesuchten Fehlschläge — das sind aggregierte Scores über Coding, Reasoning, Spezifikationskonformität und Stabilitätstests.

Die Mathematik, über die keiner spricht#

Gemini 2.5 Flash — der aktuelle Spitzenreiter — versagt bei 33% der Aufgaben. Im akademischen Kontext ist das ein Vierer-Schüler. Nicht durchgefallen, aber weit von Zuverlässigkeit entfernt.

GPT-5 — OpenAIs Flaggschiff — performt auf Münzwurf-Niveau (48%). Das liegt unter den meisten Bestehensgrenzen. Trotzdem ist dieses Modell in Unternehmensanwendungen, Coding-Assistenten und automatisierten Entscheidungssystemen weltweit im Einsatz.

Was diese Scores tatsächlich messen#

Der AI Stupid Meter evaluiert Modelle anhand sieben kritischer Achsen:

- Korrektheit — Produziert es die richtige Antwort?

- Spezifikationskonformität — Folgt es Anweisungen präzise?

- Code-Qualität — Ist generierter Code wartbar und effizient?

- Effizienz — Ressourcenverbrauch und Geschwindigkeit

- Stabilität — Konsistente Performance bei ähnlichen Aufgaben

- Ablehnungsraten — Wie oft werden valide Anfragen abgelehnt?

- Recovery-Fähigkeit — Kann es eigene Fehler korrigieren?

Ein Score von 66% bedeutet nicht “beantwortet 66% der Fragen richtig” — es bedeutet “performt adäquat über 66% unserer umfassenden Evaluierungskriterien hinweg”.

Der Vierer-Schüler führt dein Unternehmen: Real-World-Auswirkungen#

Überleg mal, was diese Fehlerraten im Produktivbetrieb bedeuten:

Für Entwickler#

- Deine KI-Code-Vervollständigung schlägt 3 Lösungen vor → 1 ist subtil falsch und führt zu einem Bug

- Das “intelligente” Refactoring? 50/50 Chance, dass es etwas kaputt macht

- Dokumentations-Generierung? Jeder dritte Docstring enthält halluzinierte Parameter

Für Geschäftsprozesse#

- Kundensupport-Chatbot mit 1.000 täglichen Anfragen → 330 frustrierte Kunden mit falschen Antworten

- Automatisierte Datenextraktion aus Rechnungen → 340 Rechnungen/Tag benötigen manuelle Prüfung

- KI-gestütztes Email-Triage → Die Hälfte deiner wichtigen Emails könnte falsch klassifiziert werden

Die versteckten Kosten#

Jeder Fehler ist nicht nur ein Fehler — er bedeutet:

- Zeit zum Debuggen von KI-generierten Fehlern

- Reputationsschaden durch falsche kundenorientierte Antworten

- Entscheidungsrisiko, wenn Führungskräfte auf fehlerhafte Analysen reagieren

Wir sind nicht im Zeitalter der künstlichen Intelligenz. Wir sind im Zeitalter der künstlichen Selbstsicherheit — Systemen, die autoritativ klingen, während sie fundamental unzuverlässig sind.

Warum das wichtig ist: Jenseits des Hype-Zyklus#

Die KI-Marketing-Maschine zeigt Demos. Benchmarks zeigen Realität. Diese Lücke zu verstehen ist entscheidend für:

1. Realistische Erwartungen setzen#

Ein Score von 66% bedeutet, du musst bauen:

- Human-in-the-loop Review-Systeme

- Automatisierte Validierungs-Layer

- Fallback-Mechanismen für kritische Pfade

2. Modell-Auswahl-Strategie#

Wähle nicht einfach das “beste” Modell. Wähle das richtige Modell für deinen Use Case:

- Hochrisiko-Entscheidungen? Nutze mehrere Modelle und Consensus-Voting

- Kreative Aufgaben? 66% könnten akzeptabel sein

- Sicherheitskritisch? Aktuelle KI ist ohne umfangreiche Guardrails nicht bereit

3. Kosten-Nutzen-Analyse#

Wenn deine KI 33% der Zeit versagt, aber das Beheben dieser Fehler 2x so viel kostet wie die KI-Einsparungen, verlierst du Geld.

4. Das Benchmark-Gaming-Problem#

Modelle werden zunehmend für spezifische Benchmarks optimiert, nicht für generelle Zuverlässigkeit. Ein hoher Score auf einem öffentlichen Benchmark garantiert keine gute Performance bei deinen spezifischen Aufgaben.

Selbst überprüfen: Live-Performance-Monitoring#

Wir haben Echtzeit-KI-Performance-Monitoring direkt in die Eliza on Steroids Plattform integriert. Das sind keine statischen Daten — sie aktualisieren sich alle 4 Stunden mit frischen Benchmarks.

👉 Live KI-Performance Stats anschauen →

Sieh welche Modelle heute wirklich performen, welche gerade degradieren, und triff informierte Entscheidungen darüber, welcher KI du vertrauen kannst.

Fazit: Die Vierer-Schüler-Revolution#

KI-Modelle sind leistungsstarke Tools, aber keine Orakel. Ein Benchmark-Score von 66% ist eine Erinnerung daran, dass menschliche Überwachung nicht optional ist — sie ist essentiell.

Die Revolution ist real, aber es ist eine Vierer-Schüler-Revolution. Plane dementsprechend.

Daten von AI Stupid Meter — unabhängiges Echtzeit-Benchmarking für KI-Modelle über 171+ Tests und 16+ Modelle. Methodik: 7-Achsen-Evaluierung, alle 4 Stunden aktualisiert.

Related Posts

- KI's Epic Fail: Wie eine KI in 2 Stunden und 12 Neustarts eine 3-Minuten-Aufgabe komplett versaut

- Der Grok Meltdown: Wenn KI ihre eigenen Daten nicht lesen kann

- Die AI-Geständnis: Wie drei KI-Systeme alles veränderten

- Das AI-Geständnis, das alles veränderte

- 'AI-Filter entlarvt: Wie Venice.ai den Status Quo herausfordert'